基础

自然语言处理(NLP)

自然语言处理PaddleNLP-词向量应用展示

自然语言处理(NLP)-前预训练时代的自监督学习

自然语言处理PaddleNLP-预训练语言模型及应用

自然语言处理PaddleNLP-文本语义相似度计算(ERNIE-Gram)

自然语言处理PaddleNLP-词法分析技术及其应用

自然语言处理PaddleNLP-快递单信息抽取

理解

自然语言处理PaddleNLP-信息抽取技术及应用

自然语言处理PaddleNLP-基于预训练模型完成实体关系抽取--实践

自然语言处理PaddleNLP-情感分析技术及应用-理论

自然语言处理PaddleNLP-情感分析技术及应用SKEP-实践

问答

自然语言处理PaddleNLP-检索式文本问答-理论

自然语言处理PaddleNLP-结构化数据问答-理论

翻译

自然语言处理PaddleNLP-文本翻译技术及应用-理论

自然语言处理PaddleNLP-机器同传技术及应用-理论

对话

自然语言处理PaddleNLP-任务式对话系统-理论

自然语言处理PaddleNLP-开放域对话系统-理论

产业实践

自然语言处理 Paddle NLP - 预训练模型产业实践课-理论

常见的对话系统

- 个人助手

•Apple Siri, Amazon Alexa, Baidu Xiaodu - 客户服务•餐厅预定、商品咨询、债务催收

- 休闲娱乐

•Microsoft XiaoIce,Replika

放域对话系统

- 检索式系统

- 生成式系统

检索式系统

生成模型

- Sequence-to-sequence

- Generative Pre-training Models

Sequence-to-sequence

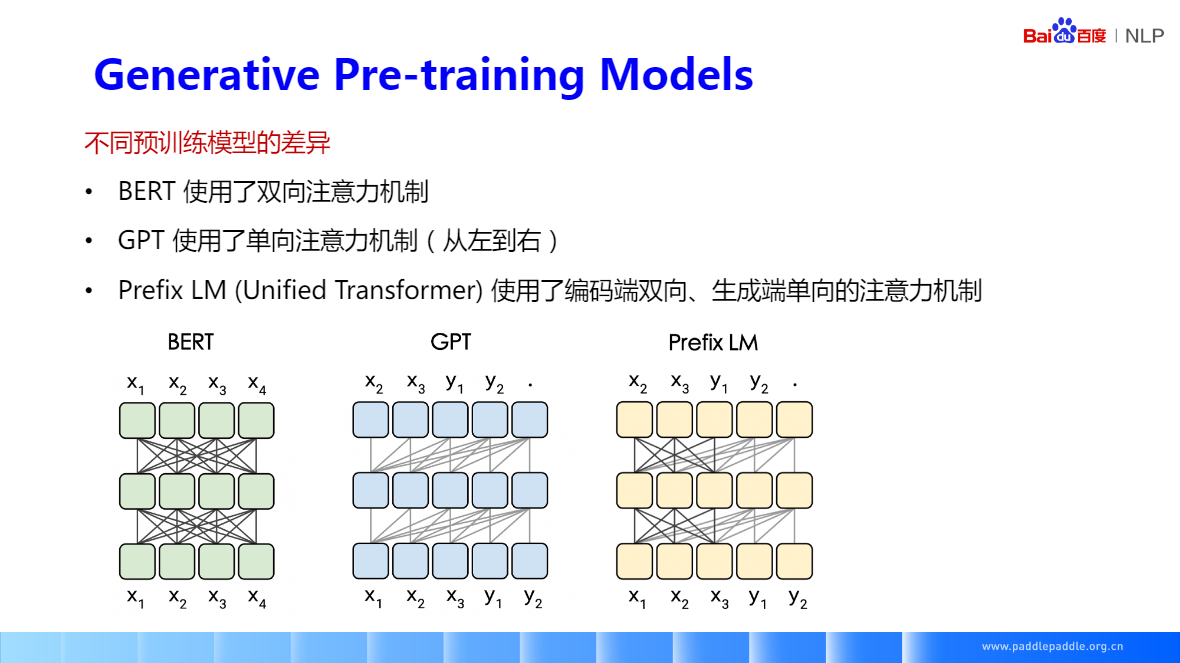

Generative Pre-training Models

- BERT 使用了双向注意力机制,每个token可以向左向右看到各个token

- GPT 使用了单向注意力机制(从左到右),是一个生成模型,每个 token只能看到自己和前他面的词,只能看到以前的,所以比较适合用来做生成任务,像平常说话也是一个词一个词的,Q:你有没有养宠物,A:我有一只猫,

- PrefixLM (Unified Transformer)使用了编码端双向、生成端单向的注意力机制,适合开放域的对话任务

解码策略

-

Greedy Decoding

-

Sampling-based Decoding

-

每一步,选取最可能的单词(i.e. argmax)

-

把选取的单词补充到input中,继续下一步解码

-

停止条件: 继续解码直到产生[EOS] 或者达到了事先定义的最大生成长度

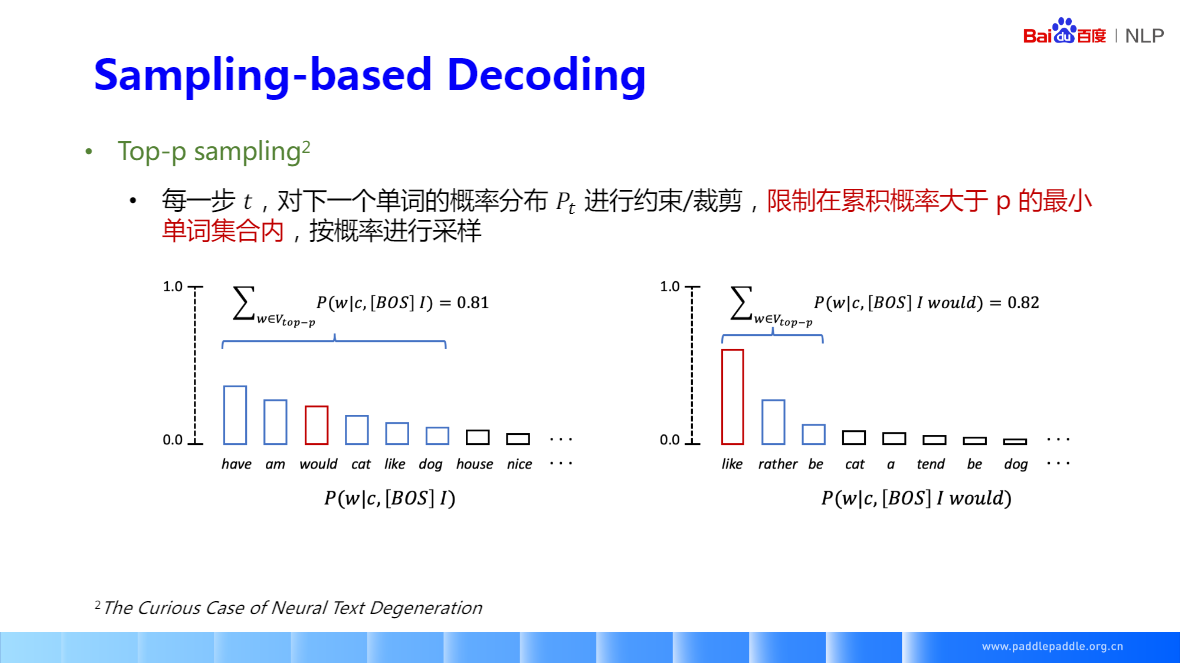

Sampling-based Decoding

解码策略–总结

- Greedy decoding 方法很简单,但效果一般较差

- Sampling-baseddecoding可以得到更多样化/随机的回复

•比较适合于开放式/创造性的生成任务,像对话、诗词、故事生成

•Top-k/p sampling 可以通过调节k/p,对生成的多样性进行控制

对话评估

- 自动评估: BLEU、Distinct

- 人工评估

BLEU

Distinct

人工评估

开放域对话模型演进历史

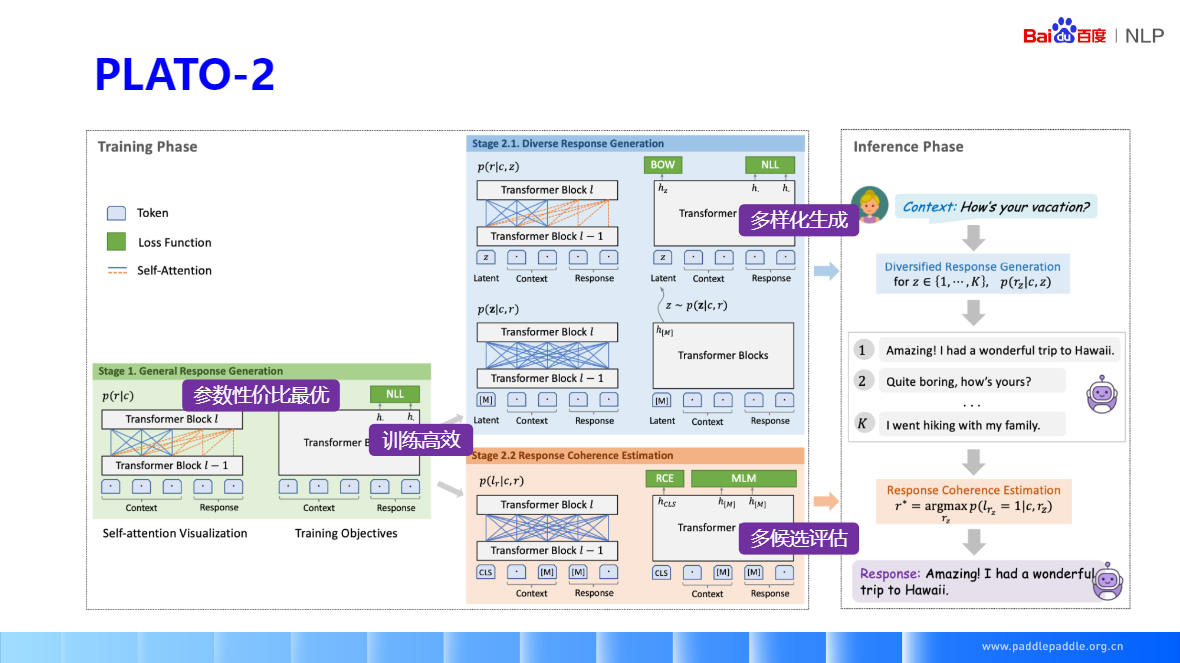

PLATO-2

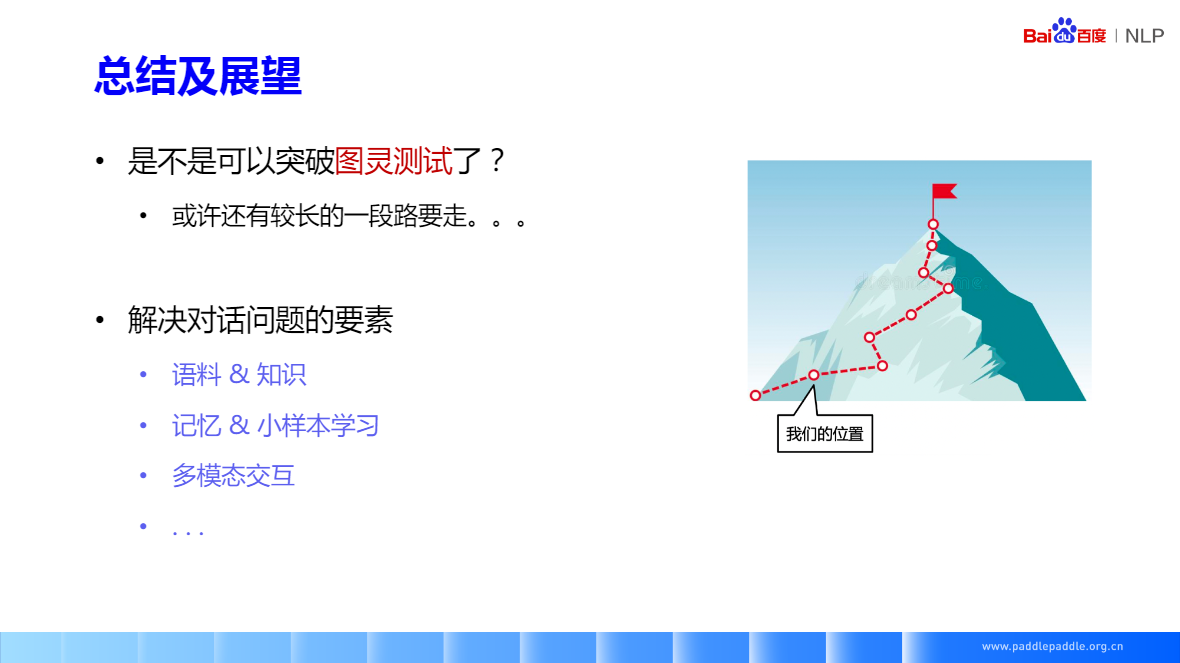

总结及展望

视频:https://aistudio.baidu.com/aistudio/course/introduce/24177?sharedLesson=1493709&sharedType=2&sharedUserId=2631487&ts=1687157269113

课件:https://aistudio.baidu.com/aistudio/course/introduce/24177?sharedLesson=1567921&sharedType=2&sharedUserId=2631487&ts=1687157254946